*** NLP / NLU 모델 학습을 위한 한국어 데이터셋 모음 ***

(8/1 UPDATE) AI HUB에 언어 인식기술 관련 멋진 데이터들이 대량 공개된 것 발견!! 특히 대화모델 학습용 데이터가 많이 포함되어 있습니다.

분류 분석 (감성분석/ 의도분류)

| 이름 | 설명 | 링크 |

| 네이버 영화 리뷰 | 네이버 영화 리뷰 데이터에 대한 긍/부정 라벨 데이터 - 학습 15만건 / 테스트 5만건 |

github |

| Toxic Comment Data | 네이버 영화 리뷰 데이터의 라벨을 상세화한 데이터 - toxic / obscene / threat / insult / identity_hate 분류 |

github |

| 3i4k | 의도분류 학습용 데이터셋 - 문장에 대해 7가지 클래스 라벨 부여 - 논문: https://arxiv.org/pdf/1811.04231.pdf |

github |

| korean-hage-speech | 한국어 혐오발언 분류 데이터셋 - 연예 뉴스 댓글에 대한 혐오 / 사회적 편견 유무 라벨 데이터 - 사회적 편견은 성별/ 기타/ 없음 세 가지로 분류 - 9,381건(7,896 / 471 / 974) |

github |

유사도 판별

| 이름 | 설명 | 링크 |

| KorNLI | 두 문장의 관계를 entailment/neutral/contradiction 으로 분류 - 학습/ 검증/ 테스트 데이터로 분리되어 있음. |

github |

| KoSTS | 두 문장의 유사도 점수를 라벨링한 데이터 - 학습/ 검증/ 테스트 데이터로 분리되어 있음. |

github |

| Question pair | 두 개의 질문이 같은 질문인지 아닌지 레이블링한 데이터 - 학습 6,888건 / 테스트 688건 제공 |

github |

| ParaKQC | 10개의 비슷한 문장에 대한 1,000개의 집합으로 구성 - 문장 유사도 데이터 494,500건 생성 가능 - 패러프래이징 데이터 45,000건 생성 가능 |

github |

자연어 질의응답 (기계독해 / MRC)

| 이름 | 설명 | 링크 |

| KorQuAD 1.0 | 한국어 기계독해를 위한 표준 데이터셋 - 리더보드 운영중 |

webpage |

| KorQuAD 2.0 | 구조를 가진 HTML 문서에 대한 기계 독해 데이터셋 - 리더보드 운영중 |

webpage |

| AI HUB 기계독해 | 한국어 기계독해를 위한 데이터셋 - SQuAD1.0 / 2.0(no-answer) 타입의 데이터 제공 - 질문 답변과 답변을 선택한 단서 제공 |

webpage |

자연어 질의응답 (일반 상식)

| 이름 | 설명 | 링크 |

| AI HUB 일반상식 QA | 일반 상식에 대한 {entity, attribute, value} 트리플 질문 -> 답변 -> 제시문에 대한 말뭉치 제공 |

webpage |

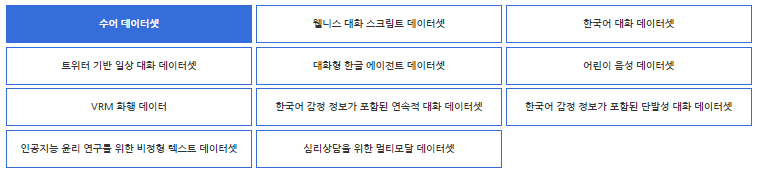

대화 모델

| 이름 | 설명 | 링크 |

| Chatbot_data | 일상 챗봇 학습용 문답 페어 11,876건 일상(0) / 이별,부정(1) / 사랑,긍정(2) 라벨 부여 |

github |

| AI HUB 한국어대화 | 소상공인, 공공민원 관련 10개 분야에 대한 1만건 이상의 데화 데이터셋 - 대화 데이터와 함께 의도(Intent) 라벨링 포함 |

webpage |

| 클로바 AI Call 데이터 | 자동 음성 인식을 위한 Goal-oriented 대화 음성 코퍼스 데이터셋 - 비영리/ 학계 소속 기관은 신청을 통해 다운로드 가능 |

github |

| 웰니스 대화 스크립트 | 세브란스 상담 데이터를 기반으로 구축한 정신 상담 데이터셋 - 359개 대화의도에 대한 5,232개 사용자 발화 - 1,023개 챗봇 발화 포함 |

webpage |

| KETI 한국어 대화 데이터 | 멀티턴 대화 데이터 758개 - 각 대화는 3~12개의 턴으로 구성 - 문장 단위로는 4,975건의 발화문 존재 |

webpage |

| 트위터기반 일상 대화 | 트위터상에 둘 이상의 화자가 대화한 내용 모음 - 1~17 턴의 데이터로 구성되어 있음 - 1차년도 데이터로 2,000 셋트가 공개됨 |

webpage |

| 대화형 한글 에이전트 | 영화/드라마/SNS등에 대한 멀티턴 대화 데이터 - 8,000개의 대화 셋트 포함 - 각 대화는 2~10 턴의 대화 포함 |

webpage |

| 한국어 감정 정보가 포함된 연속적 대화 데이터셋 |

크롤링으로 수집한 멀티턴 대화 데이터셋 - 각 발화문은 7가지 감정정보로 레이블링되어 있음 - 10,000개의 대화 셋트/ 각 대화는 약 5.6개 턴으로 구성 - 문장 단위로는 55,627건의 발화문 존재 |

webpage |

기타 (기계번역 / NER / 요약 / ...)

> 기계 번역

| 이름 | 설명 | 링크 |

| 기계 번역 AI HUB 한영 말뭉치 |

한국어-영어 160만 문장의 번역 말뭉치 - 문어체, 구어체, 대화체 등 다양한 소스 포함 |

webpage |

| 기계 번역 korean parallel corpora |

한국어 -영어 번역 한국어 - 프랑스어 번역 데이터 포함 |

github |

| 기계 번역 카이스트 중-한 데이터 |

중-한 문장 세트로 구성된 데이터셋 60,000개 문장 포함 |

webpage |

> NER

| 이름 | 설명 | 링크 |

| KoreanNERCorpus | 한국어 개체명인식 태스크 수행을 위한 데이터 | github |

| NER | 말뭉치 - 형태소 - 개체명 태깅 데이터셋 | github |

> 텍스트 요약

| 이름 | 설명 | 링크 |

| sci-news-sum-kr-50 | 네이버 뉴스 중 IT/과학 분야 기사 50개 원문 중 요약에 해당하는 문장을 태깅한 데이터셋 |

github |

RAW Corpus

| 이름 | 설명 | 링크 |

| 국립국어원 말뭉치 | 다양한 분야에 대한 방대한 한국어 raw 코퍼스 | webpage |

| 카이스트 코퍼스 | 1994~1997년 수집한 70,000,000 어절의 코퍼스 | webpage |

| 위키피디아 덤프 | 한국어 위키피디아 (추출기- 링크) |

webpage |

| 나무위키 덤프 | 나무위키 (추출기 - 링크) |

webpage |

| 한국 정치인 관련 뉴스 | 한국 정치인 19인에 대한 뉴스 수집 데이터셋 | github |

| 인공지능 윤리연구를 위한 비정형 텍스트 데이터셋 |

윤리 연구를 위해 윤리/비윤리 데이터 코퍼스 구축 1차년도: 뉴스기사 댓글 7,000만 건, 트위터 3,000만 건 2차년도: 온라인커뮤니티 (일베저장소) 댓글4,500만건 3차년도: 온라인커뮤니티 (일베저장소) 댓글2,000만건 |

webpage |

'AI > Algorithm&Models' 카테고리의 다른 글

| GPT-3, 이런 것도 된다고? (0) | 2020.07.20 |

|---|---|

| [논문리뷰] GPT3 - Language Models are Few-Shot Learners (9) | 2020.06.22 |

| [논문리뷰] ELECTRA: Pre-training Text Encoders as Discriminators Rather Than Generators (5) | 2020.05.24 |

| [논문리뷰] 블렌더(Blender) - Facebook AI의 오픈 도메인 챗봇 (0) | 2020.05.01 |

| [논문리뷰] CTRL - 자연어 생성을 위한 조건부 트랜스포머 언어 모델 (0) | 2020.04.26 |