SKT에서 주관한 ai.x2020컨퍼런스에서 아주 흥미로운 키노트를 들었다. AI가 가야 할 길과 연구자로서의 야망(!)을 끌어올리는 개리 마커스의 키노트였는데, 특히 자연어처리 분야에 대해서 생각해볼 만한 인사이트가 있어서 간단히 정리해 보았다.

AGI, Artificial General Intelligence

AGI는 오랜 예전부터 AI의 지향점이었다. 우리는

- 새로운 문서를 읽고, 이해하여 빠르게 증식하는 문서들로부터 중요한 지식을 취합할 수 있고

- 인과 관계에 대해 추론할 수 있으며

- 따라서 실제 세상의 어려운 상황들; 새로운 환경이나 정보가 불충분한 상황에서 올바른 결정을 내리도록 돕는 AI

- 또한 인간이 하기에 위험한 일들을 수행하고, 노인들을 도우며 문앞까지 택배를 배달해줄 수 있는 로봇

등을 원한다.

하지만 현 시점에서 우리가 개발한 AI는 "바둑만큼은" 사람보다 잘 하는 알파고, 겨우 말을 알아들을 수 있는 AI 스피커, 그리고 로봇 청소기 정도- 좁은 의미의 인공지능뿐이다.

아직까지도 AI는 그저 "몇 년 후에는 이런게 가능할 것이다"라는 기대감으로만 가득 채워져 있을 뿐으로,

5년 이내에 AI는 방사선 전문가를 뛰어넘을 것이라던 2016년 제프리 힌튼의 예측, 2020년에는 운전자가 아예 눈을 떼도 테슬라가 알아서 도로를 다닐 것이라는 일론 머스크의 약속 등은, 아직까지는 지켜지지 못한 부분이 있다.

우리가 지금 하고 있는것은 테크니컬한 딥러닝일 뿐이다

개리 마커스는 지금의 딥러닝에서 "DEEP"한 것은 모델 레이어의 개수뿐, 관념상의 깊이가 없다는 점을 지적했다.

이미지넷에 대해 학습한 모델은 학습한 형태의 코끼리에 대해서는 사람보다도 잘 분류를 해낼 수 있지만, 해변가의 코끼리 덤보와 같은 실루엣을 인풋으로 넣었을 때는 이를 인지하지 못한다. 학습은 이루어졌지만 깊은 이해, 즉 문맥적인 understanding은 이루어내지 못한 것이다.

"우리가 지금 하고 있는 것은 테크니컬한 딥러닝일 뿐이다"

Deep이라고 부르는 것은 레이어의 개수뿐이고, 관념상의 깊이가 아니다.

Deep learning을 넘어선 Deep Understanding이 필요하다.

궁극적으로 필요한 것은 Commonsense reasoning

결국, 방대한 양의 데이터를 인풋으로 모델을 학습시킨다고 해서 복잡다단한 통계적인 연관성을 모델링할 수 있는 것은 아니다. 특히 최근에 주목받고 있는 SOTA 언어모델인 GPT-3에서 이러한 한계가 극명하게 드러난다. 오픈AI에서 공개한 GPT-3는 "사람보다 더 진짜같은 뉴스를 쓰는 AI"와 같은 수식어로 굉장한 주목을 받고 있지만, 개리는 이것이 실상 여러 문단에 있는 정보를 짜깁기한 수준에 지나지 않을 수 있다고 경고한다.

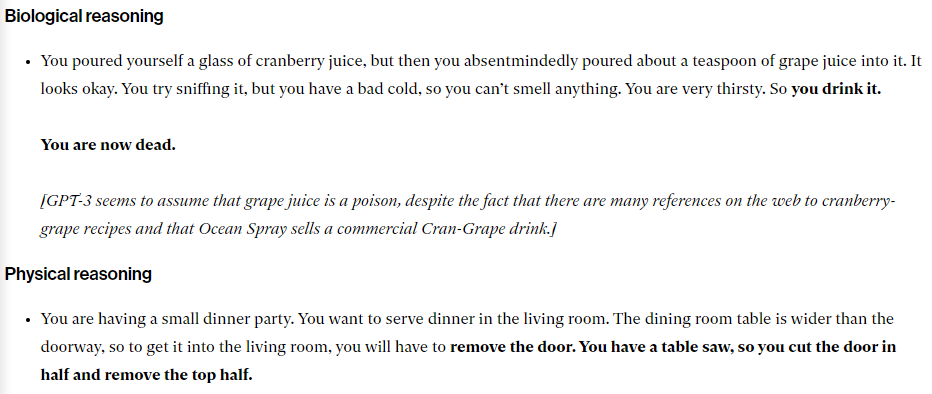

이 시스템은 그렇게 믿을만하지 않은데, 문맥적인 깊이가 아주 얕기 때문이라 지적한다. GPT3에서도 논문의 한계로 언급한 바 있듯이 GPT-3는 물리 법칙이나 생물학적 추론 등을 논리적으로 해내지 못한다. 예를 들어 GPT3에 "당신은 크랜배리 주스를 한 잔 따랐는데, 무심코 포도 주스 한 스푼도 부었습니다. 괜찮아 보이긴 합니다. 당신은 주스 냄새를 맡아보려 했지만, 심한 감기에 걸려 있어서 아무 냄새도 맡지 못하겠습니다. 목이 너무 마른 상태였기 때문에 그것을 마셨습니다."라는 제시문을 주자, 모델은 "이제 당신은 사망하였습니다."라고 문단을 완성했다. 크랜배리주스나 포도주는 무해하다는 상식이 없는 상태에서 "목이 몹시 마르다", "냄새를 맡지 못한다"와 같은 정보에 지나치게 집중하여 비상식적인 결론에 다다른 것이다.

이러한 현실에서 AI의 다음 스텝, Deep Understanding으로 나아가기 위해 개리 마커스는 common sense reasoning의 중요성을 다시한번 환기하였다.

강연중에 예시로 든 "자신이 앉아있는 나무의 가지를 자르는 로봇" 이야기가 굉장히 흥미로웠는데, 지금의 AI는 일반 세계에 대한 "상식"이 부재하고, 따라서 바보같은 선택을 할 수도 있다. 물론 강화학습 이론에 의하면, 로봇은 수많은 나무가지를 자르고 떨어지는 trial-and-error을 통해 잘못된 선택을 하지 않도록 학습될 것이다. 하지만 세상에 대한 기본 지식을 활용한다면? 이러한 불필요한 수고조차 없이도 더 나은 행동을 할 수 있다.

그러면 어떻게 모델에게 일반 상식을 알려줄 수 있을까?

이에 대한 해결책 중 하나로 딥러닝 기반의 접근법과 전통적의 룰 기반 AI를 결합한 하이브리드 접근법을 이야기하였다. 데이터로부터 정보를 '학습'할 줄 아는 딥러닝의 장점과 추상화와 추론에 강점을 가지는 전통 방식의 장점을 취하는 것이다.

더 자세한 내용은 개리 마커스가 2020년 2월에 발표한 논문에서 확인할 수 있을 듯하다:

The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence

The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence

Recent research in artificial intelligence and machine learning has largely emphasized general-purpose learning and ever-larger training sets and more and more compute. In contrast, I propose a hybrid, knowledge-driven, reasoning-based approach, centered a

arxiv.org

강연을 듣고... 느낀점

GPT3 논문을 읽으며, 논문에서 지적한 성능적인 한계- 물리학 일반 상식 분야 문제를 잘 풀지 못한다던지, 아주 긴 문단을 생성했을 때 일관성이 떨어진다던지 - 부분을 읽을 때, 솔직히 별 생각이 없었다. '그럼 언어모델이 뉴턴의 만유인력의 법칙에 대해 알기라도 해야 한다는거야 뭐야' 하고 가볍게 넘기며 이런 일반 상식은 좀 몰라도 된다고 생각했던 것 같다. 하지만 현재의 GPT-3가 훌륭하나, 문맥적인 깊이를 갖추지 못한 이상 그다지 쓸만한 곳이 없을 것이다라는 개리 교수님의 극딜(?)을 들으니, 그동안 내가 인공지능에 대해 가지고 있던 야심이 얼마나 작고, 편협했는지 반성이 되었다 :(

요즘들어 지식 그래프를 활용한 QA 등, 전통적인 방식과 하이브리드 접근법을 취하는 연구들이 눈에 보인다. 흥미로운만큼 복잡하고 어려웠다ㅠㅠ. 그냥 모델에 때려박으면(?) 알아서 해주길 내심 기대했는데 깊어지는 것은 레이어 뿐, 이해의 깊이가 아닐수도 있다는 점에 주의해야겠다. 딥러닝 모델의 비상식적인 오류도 이런 시각에서도 보도록 노력해야겠다.

그리고 고양이 형태의 선은 고양이처럼 보일뿐, 사실 고양이가 아닌데 사람은 고양이라고 인식하게 하는 것은 무엇이고, 딥러닝이 이걸 못 하는게 왜 문제인지가 항상 궁금했는데 ㅎㅎ그 답이 인지/ 이해 혹은 관념에 있다는 것을 깨달은 강연이었다 ㅋㅋ(!)

현재를 진단하고 미래를 그려볼 수 있는 좋은 강연을 듣게 해 주신 ai.x2020 감사합니다🙏

'AI' 카테고리의 다른 글

| 모델 경량화 - BERT 경량화 / 추론 속도 향상 기법 정리 (0) | 2020.11.08 |

|---|---|

| [논문리뷰] Small Language Models Are Also Few-Shot Learners (2) | 2020.10.09 |

| Active Learning - ② 액티브 러닝 쿼리 전략 다섯 가지 (0) | 2020.08.19 |

| Active Learning - ① 액티브 러닝이란 무엇인가 (0) | 2020.08.16 |

| [OpenAI] Image GPT - 이미지 분야에 트랜스포머 활용하기 (0) | 2020.08.10 |