휴가 낸 김에 AI 연구 방향에 대해 평소 가지고 있던 생각을 글로 적어 보자 🦊

사고는 언어의 틀 속에 존재하고, 따라서 우리가 사용하는 말의 체계에 의해서만 세상을 인지한다.

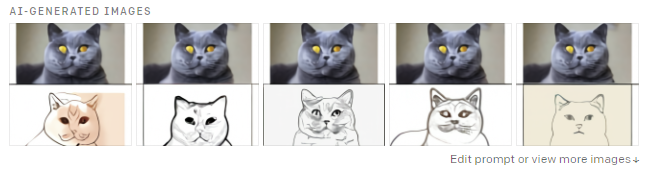

예를 들어 아래의 사진을 보고, 일반적인 사람은 일반적인 <고양이> 사진이라고 판단할 것이다.

고양이에 관심이 많은 사람이라면 <벵갈 고양이> 사진이라고 생각할 것이며 <호랑이 무늬> 등을 연상할 수도 있다.

이토록 인간의 사고에서 개념이란, 언어 체계에서 다른 말과의 관계에 의해 결여된 관념으로 정의된다.

반면에 내가 좋아하는 속담 중에 이런 말이 있다.

[ 백문이 불여일견 ]

" 털 무늬는 스팟(점박이), 로젯(표범 무늬), 마블 등의 타입이 있다. 스폿 타입은 토종 고양이 중에도 비슷한 무늬를 가진 것이 있으나(그래서 잘 모르는 사람은 코숏으로 오해하는 경우도 있다), 명백한 차이가 존재한다. 기본적으로 벵갈은 호랑이 모양의 전신수트를 몸 전체 발끝까지 깔끔하게 입은 유전자를 가져서 다리의 양말처럼 신은 하얀 색깔의 무늬 부분이 없다. 또한 턱 밑에 무늬가 없으며, 배에 동그란 점(스팟)이 많이 있다. 육구 색깔이 검다는 점도 특징. "

- 출처 : 나무위키, 벵갈 고양이

벵갈 고양이에 대한 기나긴 설명 텍스트를 읽는 것보다 사진을 한 번 보는 것이 해당 개념을 이해하는 데에 도움이 된다.

반대로, 사진만 보는 것보다는 텍스트를 통해 다리에 하얀 색깔의 무늬가 없다던지 배에 점이 많다던지 하는 세세한 부분을 관측할 수도 있다.

벵갈 고양이의 냄새, 울음소리, 털의 감촉 등을 설명해 놓은 텍스트와, 실제 오감으로 느낄 수 있는 감각들도 마찬가지이다.

이렇게 우리 사람은 감각 기관과 그에 대한 언어 체계를 복합적으로 사용하여 세상을 인지한다.

신경을 통해 들어오는 자극과 추상적인 언어의 틀은 상호작용하여 인간의 사고를 형성한다.

자연스럽게 AI 연구에 있어서도, 입력 정보와 언어간의 상호작용에 따른 시너지 효과를 낼 수 있지 않을까 하는 생각이 든다.

시각/ 청각 입력에 상응하는 텍스트를 통해 기계는 세상에 대해 더 나은 지식을 학습할 수 있을지도 모른다.

특히 수많은 데이터로부터 기계가 스스로 representation을 학습하는 self-supervised learning의 성공 사례는

multimodal 딥러닝 연구를 통해 언어와 시각 모두에 있어 AI의 성능을 강화할 수 있을지도 모른다는 비전을 가지게 한다.

향후에는 멀티모달 데이터에 대한 자기지도학습, 아키텍처 디자인,

그리고 이러한 모델링에 필요한 데이터 수집 방향성 등에 대해 연구해보고 싶다.

멀티모달 연구 사례들

[ OpenAI DALL-E ]

텍스트 입력에 대해 이미지를 생성해내는 120억개 파라미터의 GPT 모델

(예) 아보카도 모양의 의자를 그려줘

(예) 위에 있는 고양이 사진에 대해 스케치를 그려봐

작년에 OpenAI가 발표한 GPT-3 모델은 트랜스포머 계열의 뉴럴네트워크 모델을 scale-up함으로써 다양한 텍스트 생성 과제를 뛰어나게 수행할 수 있다는 것을 보였다. ImageGPT모델을 통해 트랜스포머 네트워크를 활용하여 이미지를 잘 생성할 수 있음도 확인하였다. 이에 OpenAI는 언어를 사용하여 시각적인 컨셉을 다룰 수 있는 모델을 연구, DALL-E를 발표하였다.

GPT-3와 마찬가지로 DALL-E는 트랜스포머 계열의 언어 모델로, 텍스트와 이미지를 같은 형식으로 입력받을 수 있다.

최대 1,280 토큰까지 입력을 받을 수 있으며, autoregressive LM 스타일로 모델을 학습하였다.

이 과정에서 DALL-E는 이미지를 from-scratch로 생성할 수 있게 되었을 뿐만 아니라,

어떠한 이미지를 이미지 조각만 가지고도 텍스트 입력 내용과 일관된 전체 이미지를 완성하는 능력을 가지게 되었다.

> OpenAI DALL-E : https://openai.com/blog/dall-e/

> GPT-3 설명 : https://littlefoxdiary.tistory.com/44

> Image GPT 설명 : https://littlefoxdiary.tistory.com/51

(추가 업데이트 예정)